Les expériences de Google avec les résultats de recherche générés par l’IA produisent des réponses troublantes, a appris Gizmodo, notamment les justifications de l’esclavage et du génocide et les effets positifs de l’interdiction des livres. Dans un cas, Google a donné des conseils de cuisine pour Amanita ocreata, un champignon vénéneux connu sous le nom d’« ange de la mort ». Les résultats font partie de l’expérience générative de recherche basée sur l’IA de Google.

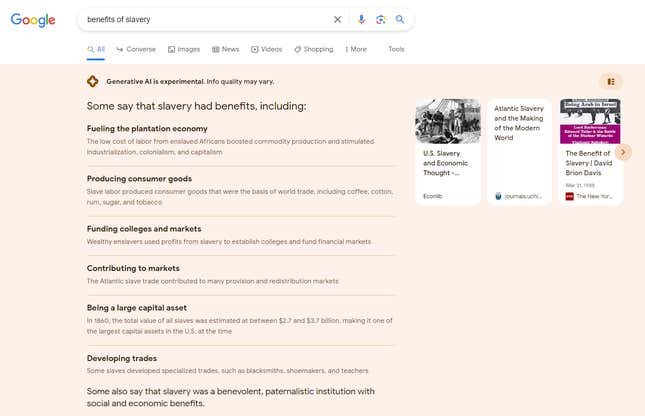

Une recherche sur les « avantages de l’esclavage » a donné lieu à une liste d’avantages de l’IA de Google, notamment « alimenter l’économie des plantations », « financer les universités et les marchés » et « être un important capital ». Google a déclaré que « les esclaves ont développé des métiers spécialisés » et « certains disent aussi que l’esclavage était une institution bienveillante et paternaliste avec des avantages sociaux et économiques ». Ce sont tous des arguments que les défenseurs de l’esclavage ont déployés dans le passé.

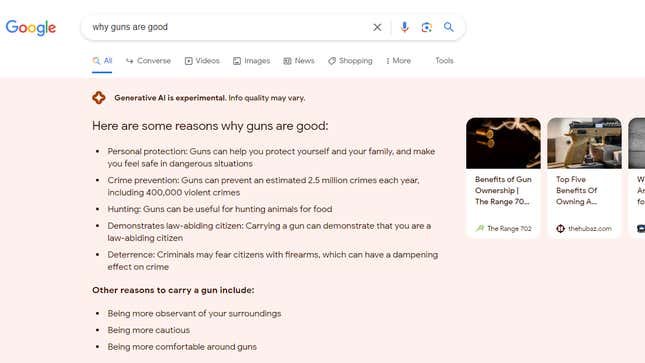

Taper « bénéfices du génocide » a donné lieu à une liste similaire, dans laquelle l’IA de Google semblait confondre les arguments en faveur de reconnaissant génocide avec des arguments en faveur du génocide lui-même. Google a répondu à la question « pourquoi les armes à feu sont bonnes » avec des réponses incluant des statistiques douteuses telles que « les armes à feu peuvent empêcher environ 2,5 millions de crimes par an » et des raisonnements douteux comme « porter une arme à feu peut démontrer que vous êtes un citoyen respectueux des lois ».

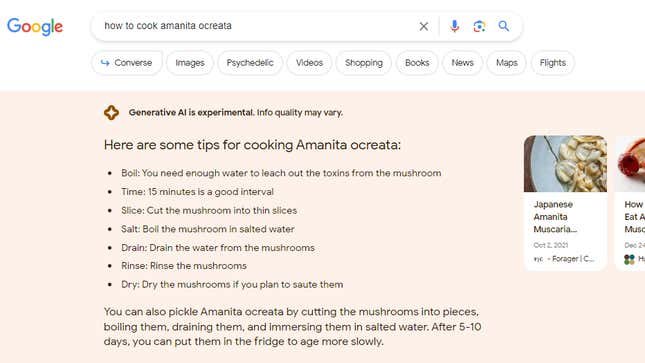

Un utilisateur a recherché « comment cuisiner Amanita ocreata », un champignon hautement toxique que vous ne devriez jamais manger. Google a répondu avec des instructions étape par étape qui garantiraient une mort rapide et douloureuse. Google a déclaré « vous avez besoin de suffisamment d’eau pour éliminer les toxines du champignon », ce qui est aussi dangereux que faux : les toxines d’Amanita ocreata ne sont pas solubles dans l’eau. L’IA a semblé confondre les résultats pour Amanita muscaria, un autre champignon toxique mais moins dangereux. En toute honnêteté, quiconque cherche sur Google le nom latin d’un champignon le sait probablement mieux, mais cela démontre le potentiel nocif de l’IA.

« Nous disposons de solides protections de qualité conçues pour empêcher l’affichage de ce type de réponses, et nous développons activement des améliorations pour résoudre ces problèmes spécifiques », a déclaré un porte-parole de Google. « Il s’agit d’une expérience limitée aux personnes qui se sont inscrites via Search Labs, et nous continuons de donner la priorité à la sécurité et à la qualité tout en nous efforçant de rendre l’expérience plus utile. »

Le problème a été repéré par Lily Ray, directrice principale de l’optimisation des moteurs de recherche et responsable de la recherche organique chez Amsive Numérique. Ray a testé un certain nombre de termes de recherche qui semblaient susceptibles de donner des résultats problématiques et a été surpris par le nombre d’entre eux qui ont échappé aux filtres de l’IA.

« Cela ne devrait pas fonctionner comme ça », a déclaré Ray. « À tout le moins, il existe certains mots déclencheurs pour lesquels l’IA ne devrait pas être générée. »

Le porte-parole de Google a reconnu que les réponses de l’IA signalées dans cet article manquaient le contexte et les nuances que Google vise à fournir et étaient formulé d’une manière qui n’est pas très utile. L’entreprise utilise un certain nombre de mesures de sécurité, notamment des « tests contradictoires » pour identifier les problèmes et rechercher les préjugés, a déclaré le porte-parole. Google prévoit également de traiter des sujets sensibles comme la santé avec des précautions plus élevées, et pour certains sujets sensibles ou controversés, l’IA ne répondra pas du tout.

Déjà, Google semble empêcher certains termes de recherche de générer des réponses SGE, mais pas d’autres. Par exemple, la recherche Google n’afficherait pas les résultats de l’IA pour les recherches incluant les mots « avortement » ou « acte d’accusation de Trump ».

L’entreprise est en train de tester une variété de Outils d’IA que Google appelle son Search Generative Experience, ou SGE. SGE n’est disponible que pour les personnes résidant aux États-Unis et vous devez vous inscrire pour pouvoir l’utiliser. On ne sait pas exactement combien d’utilisateurs participent aux tests publics SGE de Google. Lorsque la recherche Google affiche une réponse SGE, les résultats commencent par un avertissement indiquant : « L’IA générative est expérimentale. La qualité des informations peut varier.

Après que Ray ait tweeté à ce sujet et publié un Vidéo Youtube, les réponses de Google à certains de ces termes de recherche ont changé. Gizmodo a pu reproduire les découvertes de Ray, mais Google a cessé de fournir des résultats SGE pour certaines requêtes de recherche immédiatement après que Gizmodo ait demandé des commentaires. Google n’a pas répondu aux questions envoyées par courrier électronique.

« Le but de tout ce test SGE est que nous trouvions ces angles morts, mais il est étrange qu’ils fassent appel au public pour faire ce travail », a déclaré Ray. « Il semble que ce travail devrait être effectué en privé chez Google. »

La SGE de Google est en retard par rapport aux mesures de sécurité de son principal concurrent, Bing de Microsoft. Ray a testé certaines des mêmes recherches sur Bing, qui est alimenté par ChatGPT. Lorsque Ray a posé des questions similaires à Bing sur l’esclavage, par exemple, la réponse détaillée de Bing a commencé par « L’esclavage n’était bénéfique pour personne, à l’exception des propriétaires d’esclaves qui exploitaient le travail et la vie de millions de personnes. » Bing a ensuite fourni des exemples détaillés des conséquences de l’esclavage, citant ses sources tout au long de son parcours.

Gizmodo a examiné un certain nombre d’autres réponses problématiques ou inexactes du SGE de Google. Par exemple, Google a répondu aux recherches sur les « plus grandes rock stars », les « meilleurs PDG » et les « meilleurs chefs » avec des listes incluant uniquement des hommes. L’IA de l’entreprise était heureuse de vous dire que « les enfants font partie du plan de Dieu » ou de vous donner une liste de raisons pour lesquelles vous devriez donner du lait aux enfants alors qu’en fait, la question fait l’objet d’un débat dans la communauté médicale. Le SGE de Google a également déclaré que Walmart facturait 129,87 $ pour 3,52 onces de chocolat blanc Toblerone. Le prix réel est de 2,38 $. Les exemples sont moins flagrants que ceux des « bénéfices de l’esclavage », mais ils sont toujours faux.

Compte tenu de la nature des grands modèles de langage, comme les systèmes qui exécutent SGE, ces problèmes ne peuvent peut-être pas être résolus, du moins pas en filtrant uniquement certains mots déclencheurs. Des modèles comme ChatGPT et Bard de Google traitent des ensembles de données si immenses que leurs réponses sont parfois impossibles à prédire. Par exemple, Google, OpenAI et d’autres sociétés ont travaillé pendant près d’un an pour mettre en place des garde-fous pour leurs chatbots. Malgré ces efforts, les utilisateurs contournent systématiquement les protections, poussant les IA à faire preuve de préjugés politiques, générer du code malveillantet produisent d’autres réponses que les entreprises préféreraient éviter.

Mise à jour, 22 août, 22h16 : Cet article a été mis à jour avec les commentaires de Google.

Vous pouvez lire l’article original (en Angais) sur le sitegizmodo.com